论文阅读: 综述 - A Survey on Collaborative DNN Inference for Edge Intelligence

本文最后更新于:2023年11月6日 下午

A Survey on Collaborative DNN Inference for Edge Intelligence

摘要

With the vigorous development of artificial intelligence (AI), the intelli- gent applications based on deep neural network (DNN) change people’s lifestyles and the production efficiency. However, the huge amount of computation and data generated from the network edge becomes the major bottleneck, and traditional cloud-based computing mode has been unable to meet the requirements of real-time processing tasks. To solve the above problems, by embedding AI model training and infer- ence capabilities into the network edge, edge intelligence (EI) becomes a cutting-edge direction in the field of AI. Furthermore, collabora- tive DNN inference among the cloud, edge, and end device provides a promising way to boost the EI. Nevertheless, at present, EI oriented collaborative DNN inference is still in its early stage, lacking a sys- tematic classification and discussion of existing research efforts. Thus motivated, we have made a comprehensive investigation on the recent studies about EI oriented collaborative DNN inference. In this paper, we firstly review the background and motivation of EI. Then, we clas- sify four typical collaborative DNN inference paradigms for EI, and analyze the characteristics and key technologies of them. Finally, we summarize the current challenges of collaborative DNN inference, discuss the future development trend and provide the future research direction.

随着人工智能(AI)的蓬勃发展,基于深度神经网络(DNN)的智能应用改变了人们的生活方式和生产效率。 然而,网络边缘产生的海量计算和数据成为主要瓶颈,传统的基于云的计算模式已经无法满足实时处理任务的要求。 针对上述问题,通过将人工智能模型训练和推理能力嵌入到网络边缘,边缘智能(EI)成为人工智能领域的前沿方向。 此外,云、边缘和终端设备之间的协作 DNN 推理提供了一种有前途的提高 EI 的方法。 然而,目前面向EI的协作DNN推理仍处于早期阶段,缺乏对现有研究工作的系统分类和讨论。 因此,我们对面向 EI 的协作 DNN 推理的最新研究进行了全面的调查。 本文首先回顾了EI的背景和动机。 然后,我们对四种典型的 EI 协作 DNN 推理范式进行了分类,并分析了它们的特点和关键技术。 最后,我们总结了协作DNN推理当前面临的挑战,讨论了未来的发展趋势并提供了未来的研究方向。

Introduction

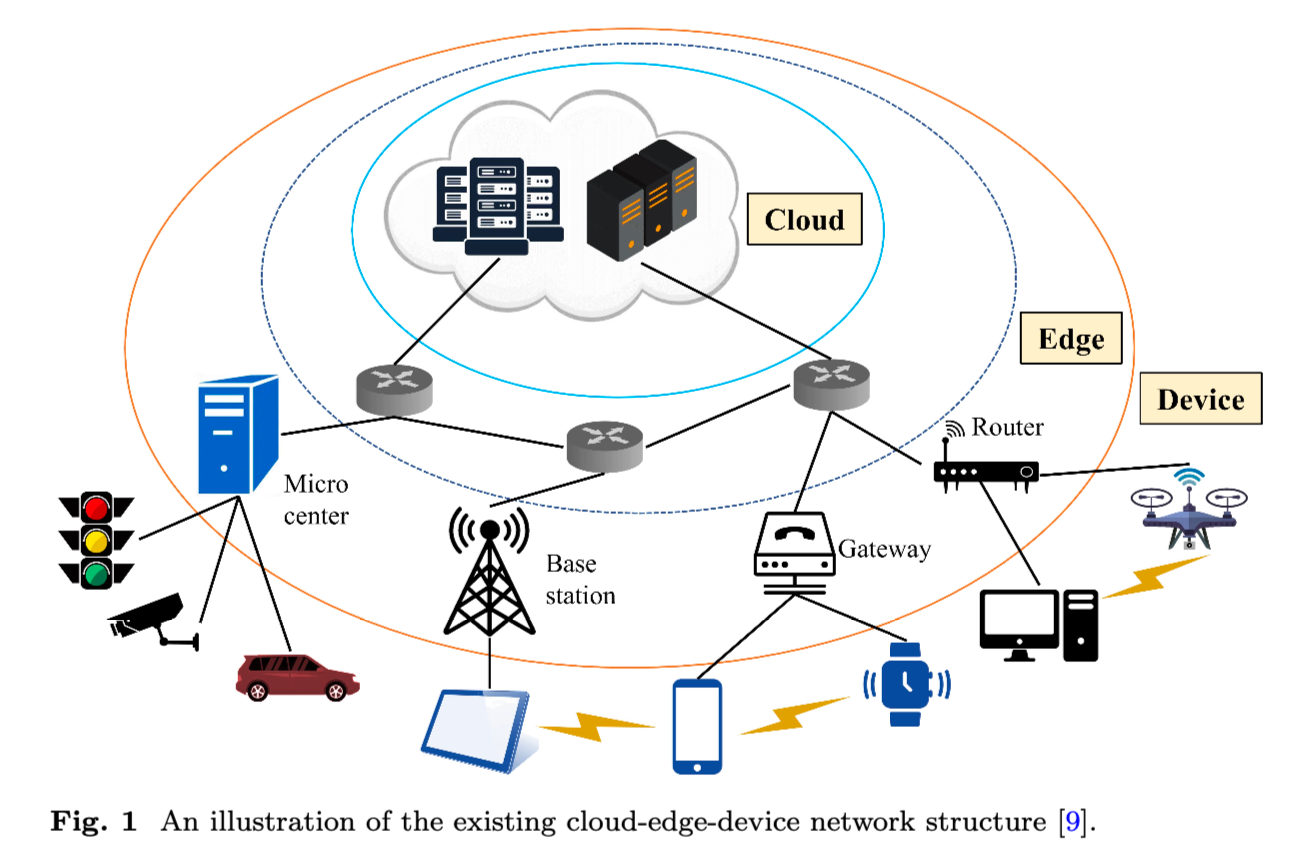

虽然 DNN 在处理计算密集型任务方面具有巨大优势,但它严重依赖传感器和其他终端设备来收集应用数据。 随着物联网技术的快速发展,全球连接的设备数量越来越庞大,每个设备上承载着大量的应用程序,导致边缘数据爆发式增长. 在这种趋势下,传统的云智能先将数据或任务传输到云中心,然后运行基于DNN的推理,给传输链路带来了沉重的负担,这也导致了不可接受的大响应延迟和日益严重的数据隐私泄露问题。 考虑到基于云的智能的这些缺点,我们设想将智能从云端推向网络边缘,从而催生了边缘智能(Edge Intelligence, EI)

引入 EI 的好处:

- low response latency, 低响应延迟

- high energy efficiency, 高能效

- privacy protection, 保护隐私

- bandwidth consumption reduction, 减少带宽消耗

- throughput improvement, 提高吞吐量

- on-demand deployment, 按需部署

EI 推理分类:

- 单节点推理

- 多节点推理

对于大规模任务, 可以将其划分为子任务并交给多节点推理, 与单节点推理相比,多节点协同推理可以为EI的落地带来许多潜在的好处,例如更低的延迟和带宽压力、更广泛的应用场景、更低的能耗和设备租赁成本、 敏捷的任务调度策略和所涉及节点之间的资源分配.

本文行文:

具体来说,我们首先回顾一下EI的背景。

然后我们讨论协作推理的动机、定义和分类。

接下来,我们进一步回顾和分类不同结构的协同推理范式,以及它们的优化目标和高效技术。

最后,我们阐述了 EI 协作 DNN 推理中的几个挑战和机遇。

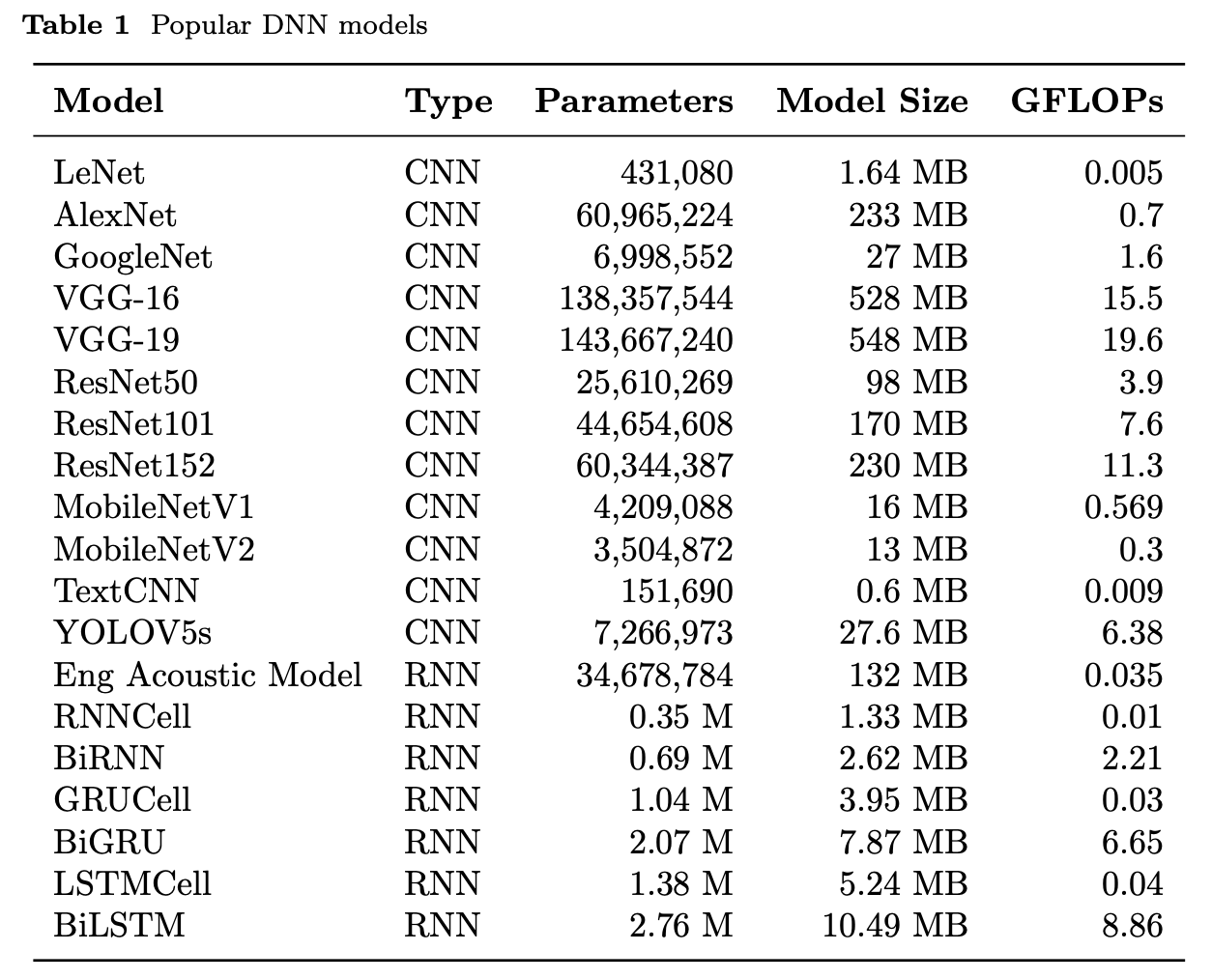

Table 1 总结了热门的 DNN 模型对于资源消耗的情况:

常见的四种协同 DNN 推理的模式 (云, 边, 端如何组合)

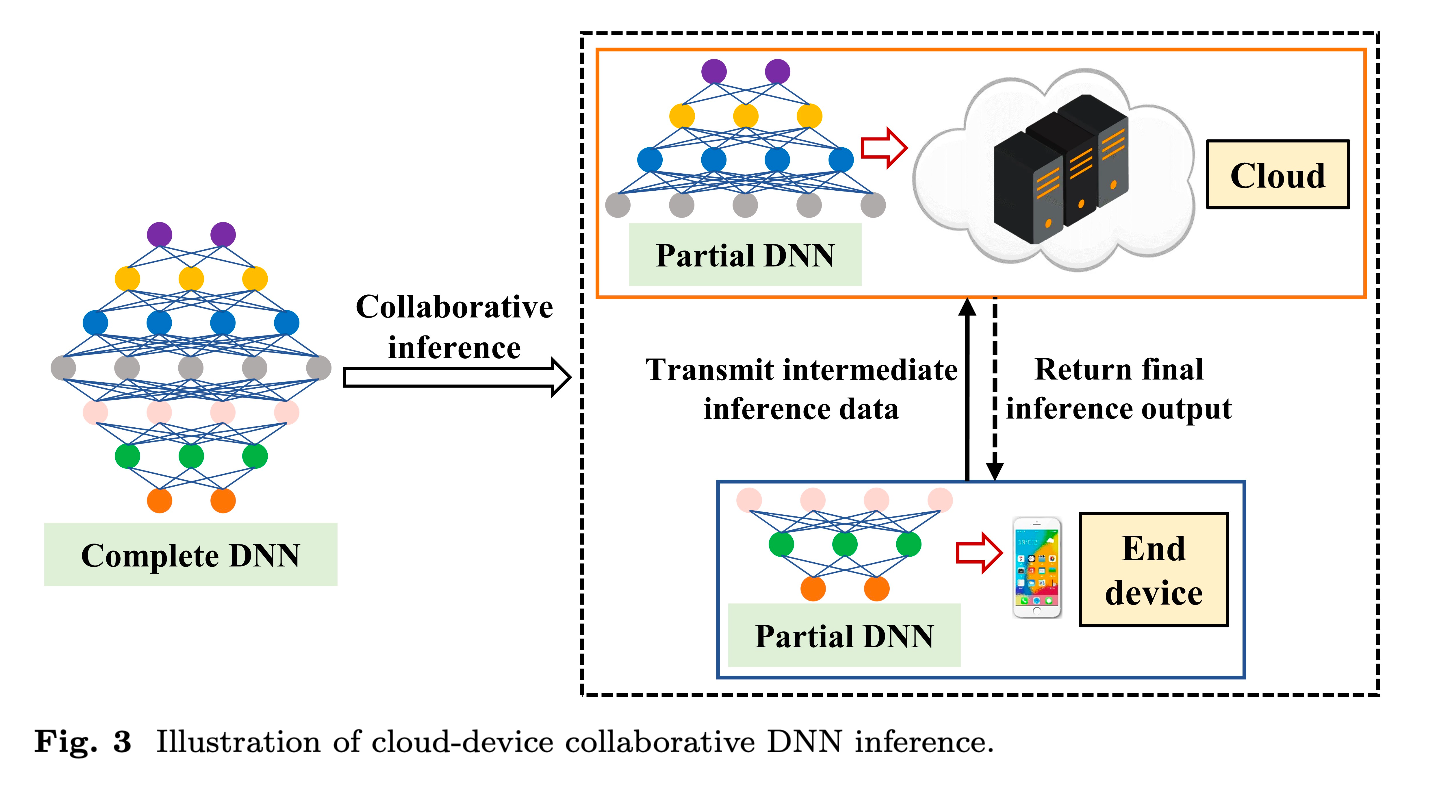

- Cloud-device collaborate DNN inference (云端协同的 DNN 推理)

DNN模型部署在云端服务器和终端设备上,通过云端和终端设备配合进行DNN推理。 终端设备会对原始数据进行部分处理,并将提取的特征信息数据传输到云端。 云端将接收剩余的数据进行推理,并将最终的决策结果发送回终端设备。 云端协同DNN推理范式会更加关注时延,通常用于移动性较弱的场景。

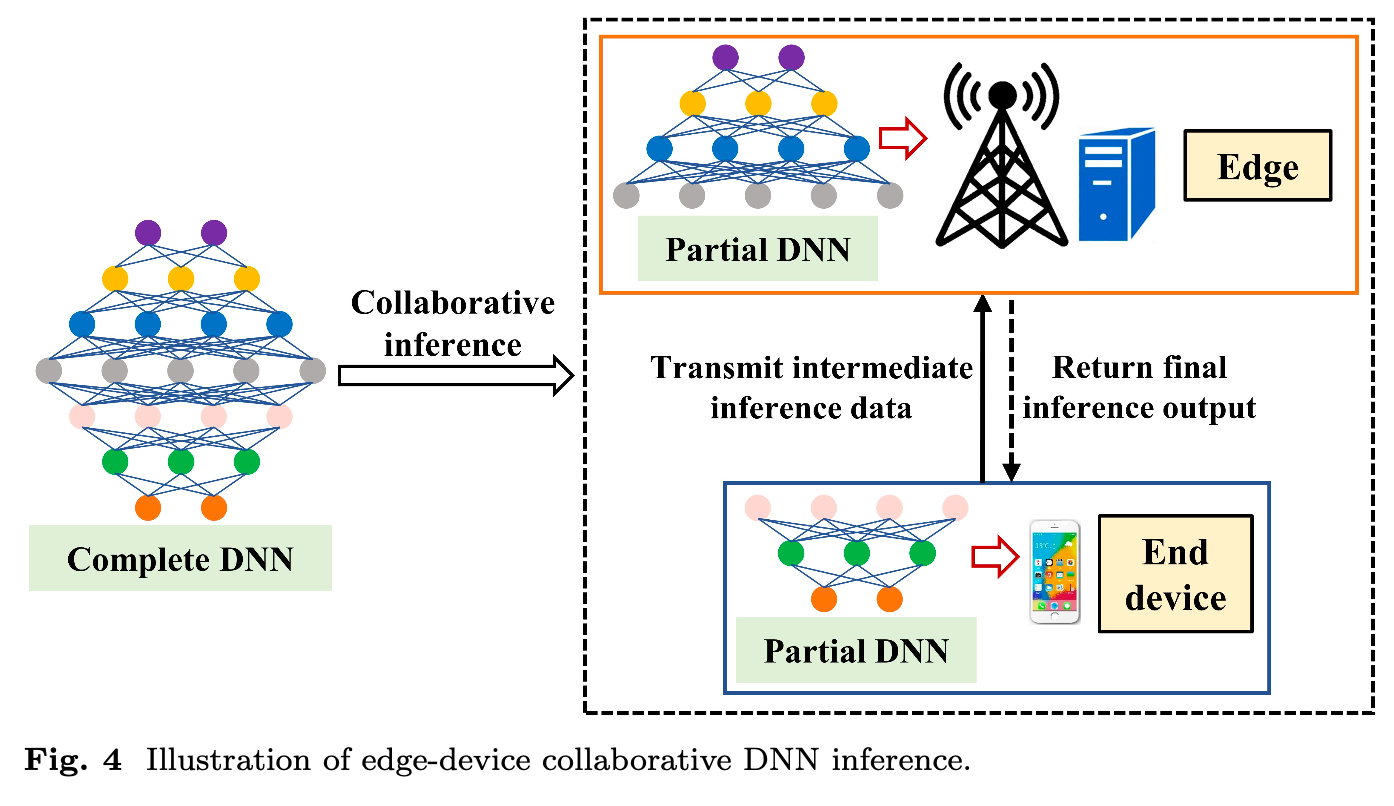

- Edge-device collaborate DNN inference (边缘设备协同的 DNN 推理)

DNN模型部署在边缘服务器和终端设备上,通过边缘和终端设备之间的协作来推断DNN模型。 模型推理是在网络边缘内进行的,这可以通过将全部或部分数据卸载到边缘节点或附近的设备来实现。 该范式注重推理准确性,可用于高度交互的应用场景。

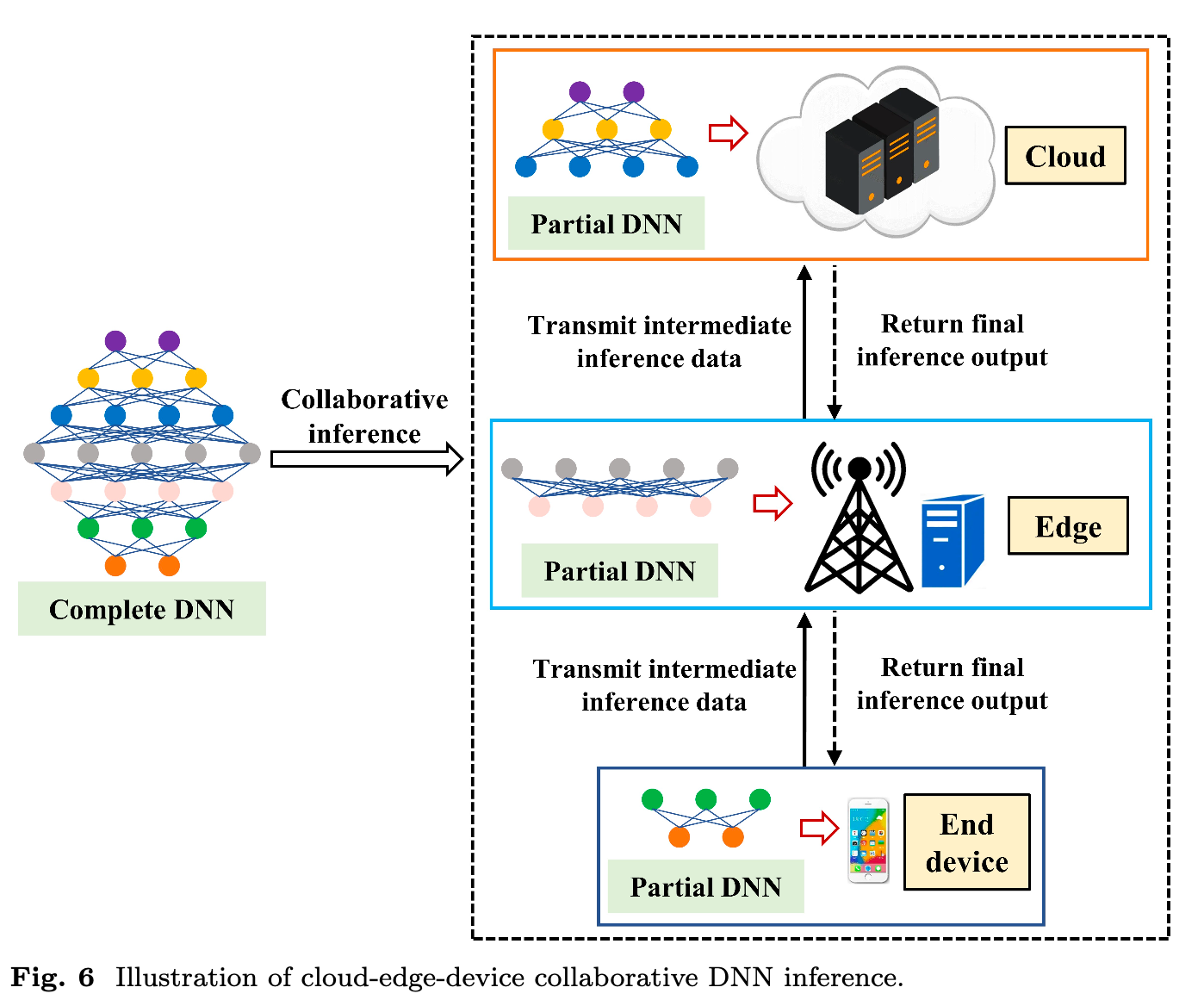

- Cloud-edge-device collaborate DNN inference (云边端协同的 DNN 推理)

将DNN模型同时部署在云服务器、边缘服务器和终端设备上,通过三者的配合推导出DNN模型。 该范例侧重于总成本和稳定性。 可用于计算量大、数据量大的场景。

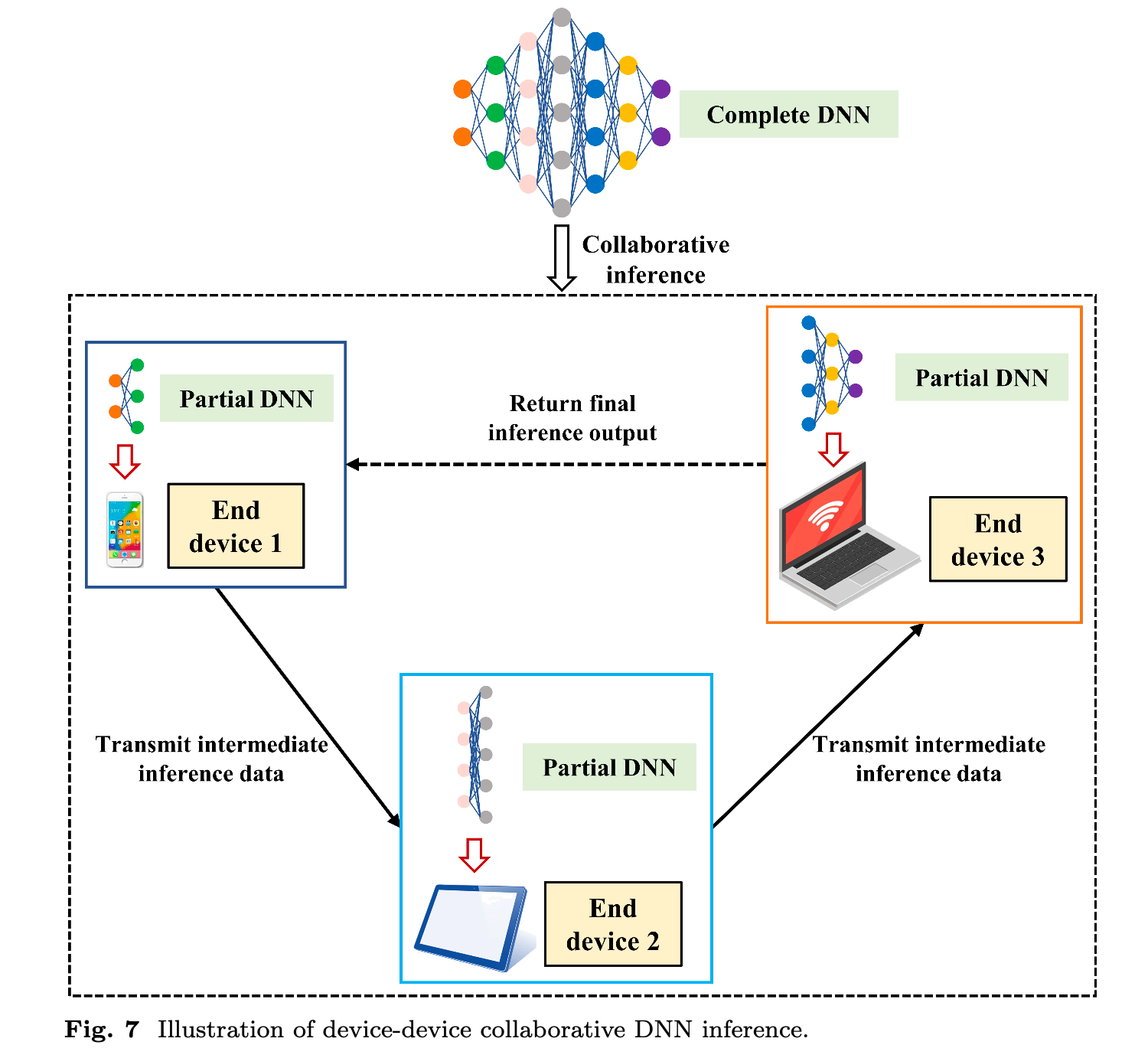

- Device-device collaborative DNN inference (设备-设备端协同的 DNN 推理)

将DNN模型部署在本地终端设备上,完全以本地协作的方式进行DNN推理。 这意味着数据将在源头附近进行处理以获得决策结果,而无需边缘服务器和云服务器的参与。 该范式侧重于推理延迟和能耗,但它可以应用于高移动性场景或一些偏远和恶劣的环境。

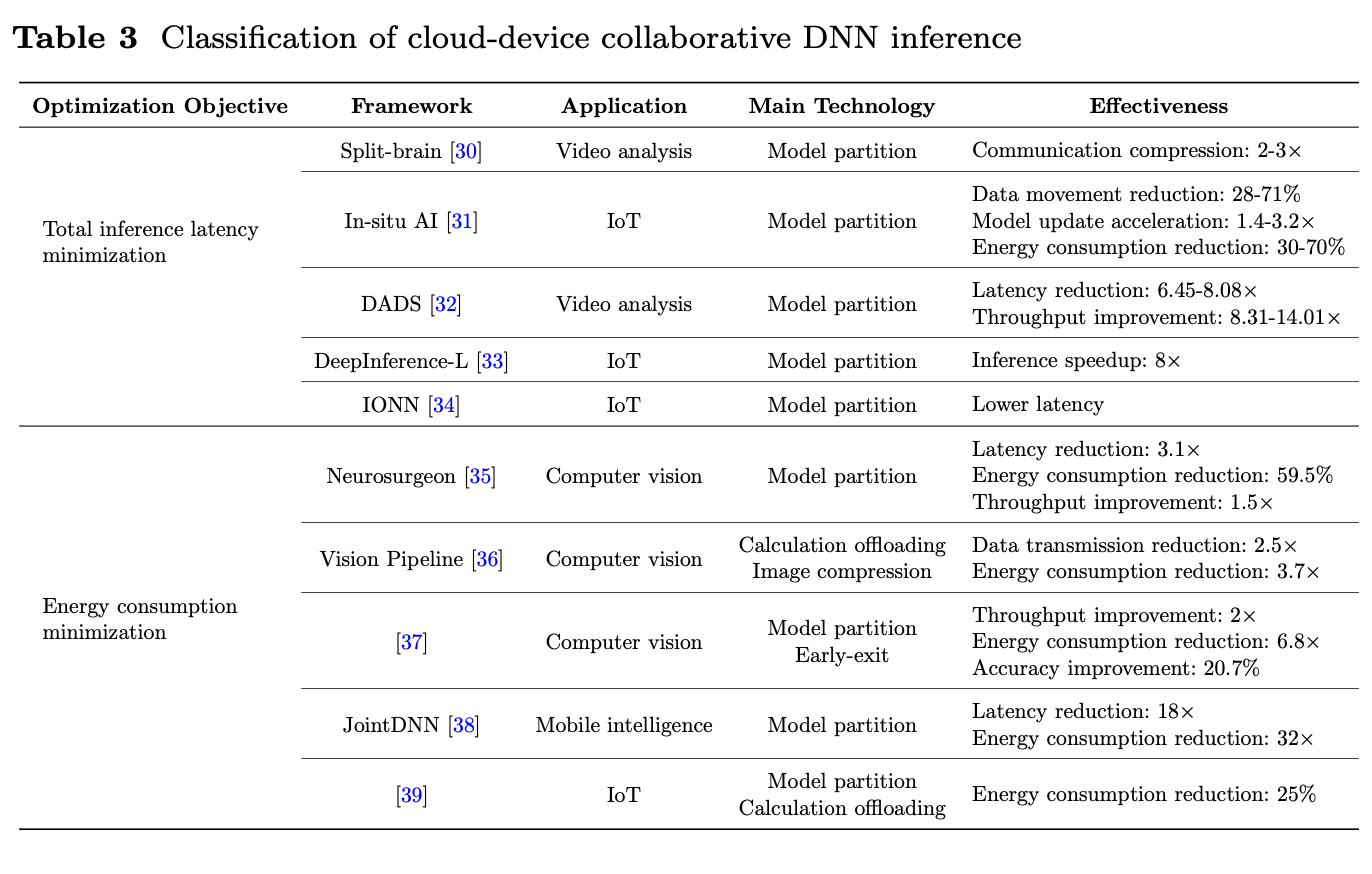

1 - Cloud-device Collaborate DNN inference

传统的纯云端DNN推理计算方法需要通过无线网络上传大量数据,如图像、视频和音频到服务器,导致较高的延迟和能源成本。 因此,数据传输成为传统纯云DNN推理的瓶颈。 如图3所示,与传统的集中式云计算框架不同,云端协同DNN推理使得终端设备和云服务器的任务调度和分配更加精准,强化了协同运行模式。 更具体地说,我们可以在边缘侧计算一部分DNN,将少量中间结果传输到云端,然后在云端计算其余部分。 DNN 的划分构成了计算和传输之间的权衡。 然而,由于云的限制,包括设备无法移动,云端协同推理只能用于移动性较弱的场景,例如商场监控或为用户提供Web服务。 考虑到云端协同推理的应用场景,性能优化会更加关注时延,因为弱移动场景下传输时间是主要问题。

工作模式:

本文将一般的 cloud-device DNN 推理的优化目标分为如下两类:

- 对推理延迟的优化 (total inference latency)

- 对消耗能源的优化 (energy consumption minimization)

难点: 如何进行 DNN 的结构划分

同时传统的 cloud-device collaborate DNN inference 具有如下的缺点:

- 在高速移动场景和恶劣通信条件下无法满足实时性和高精度需求

- 应用场景有限, 因为 cloud server 距离终端设备太远

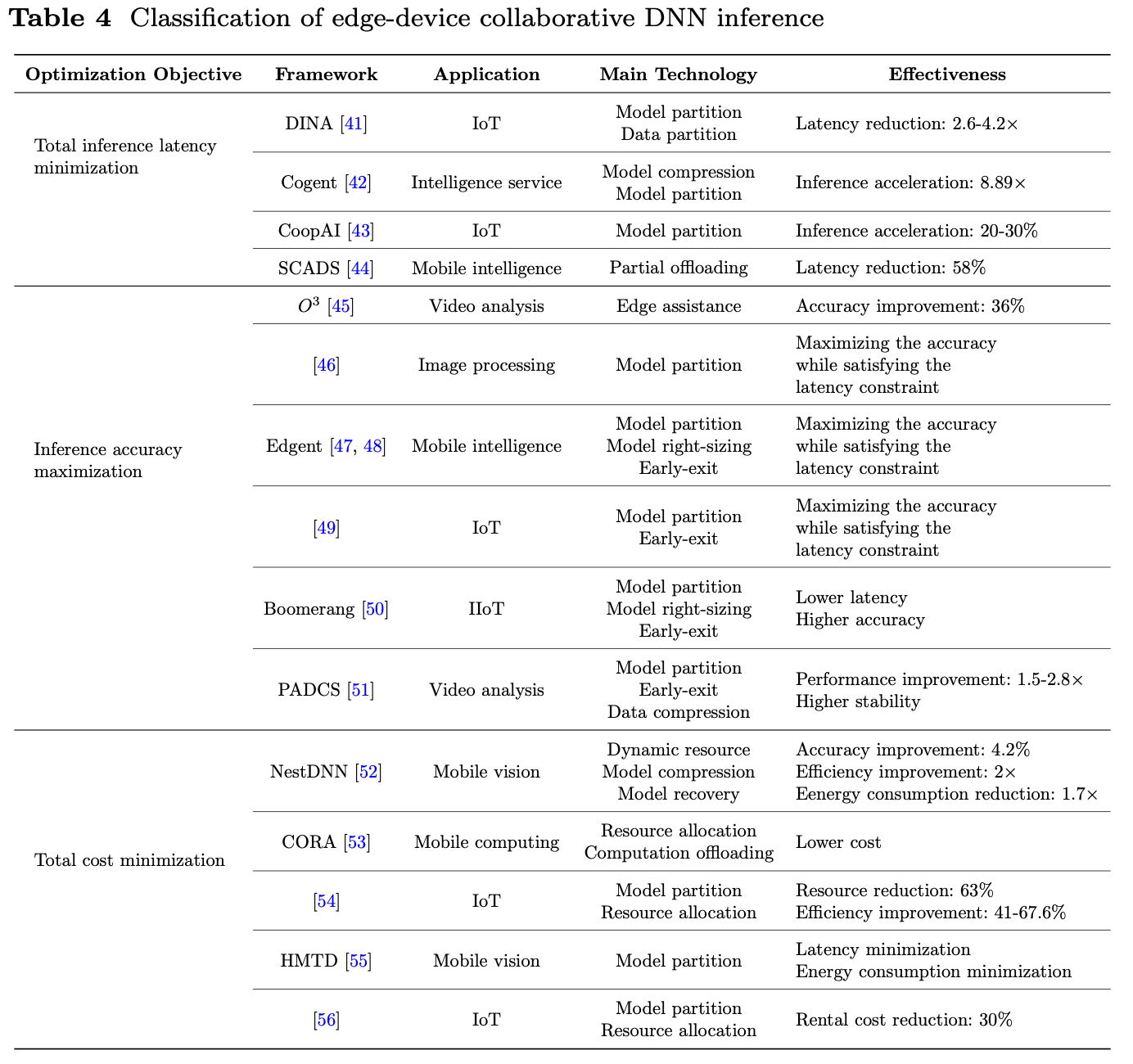

2 - Edge-device collaborate DNN inference

此种方式相当于以一种分布式的方式来减少中心站点的计算负载

本文将一般的 edge-device DNN 推理的优化目标分为如下两类:

- 对推理延迟的优化 (total inference latency)

- 对推理准确度的优化 (inference accuracy maximization)

- 对整体消耗的优化 (total cost minimization)

与纯云端模式和云端协同模式相比, 端端协同的 DNN 推理具有如下优点:

- 更低的延迟 (距离更近)

- 更低的成本 (通信距离变短, 通信成本降低)

缺陷:

- 实时性能的限制

- 带宽取决于边缘服务器和物联网设备之间的可用带宽

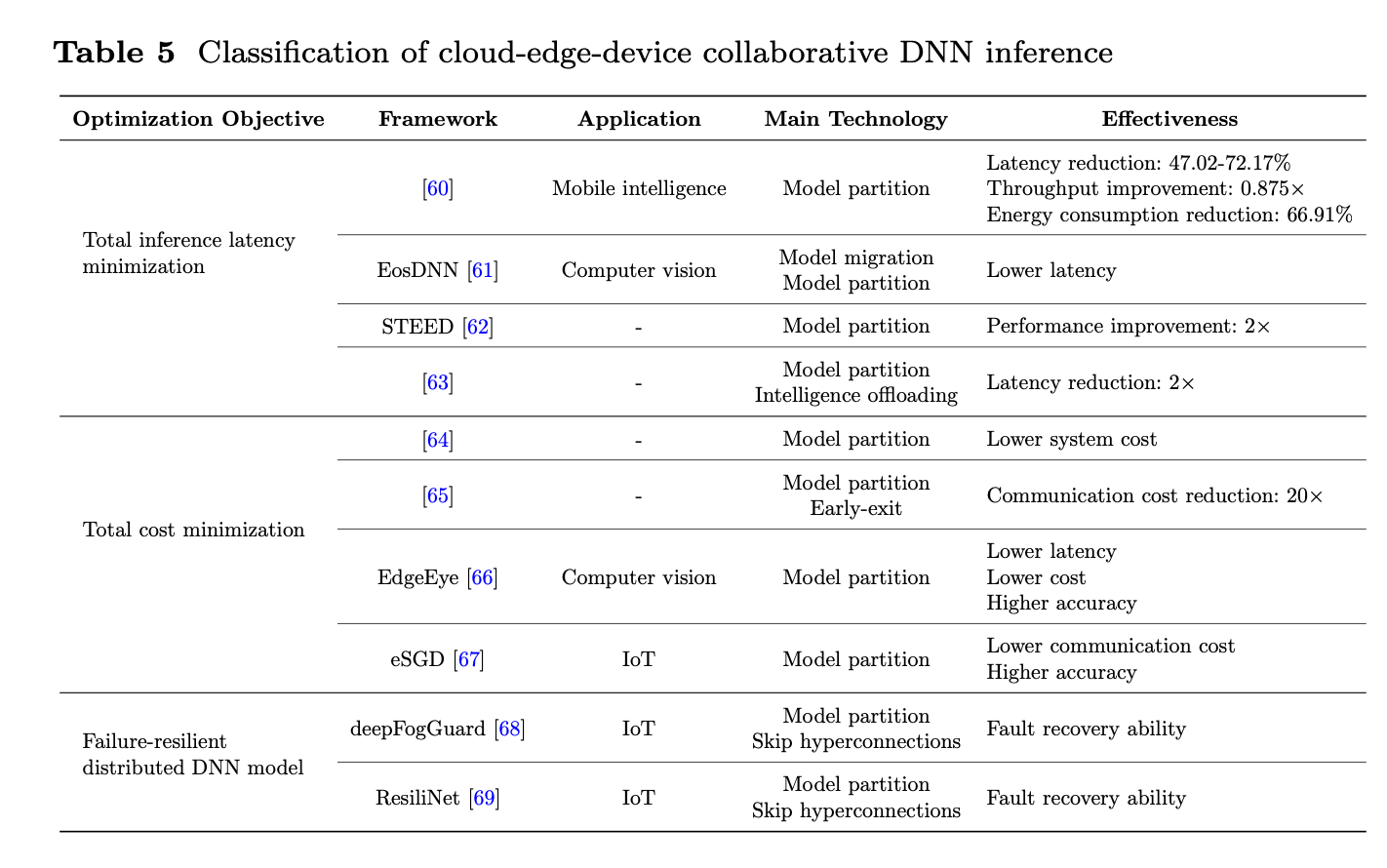

3 - Cloud-edge-device collaborate DNN inference

云边端协同的 DNN 的主要思想是利用云计算高算力和边缘计算低传输延迟的特点, 增强设备之间的交互, 提高系统的灵活性和扩展性.

由于参与设备的数目的增加, 云边端协同推理的性能的优化目标主要考虑系统的总成本和稳定性

本文将一般的 cloud-edge-device DNN 推理的优化目标分为如下三类:

- 对推理延迟的优化 (total inference latency)

- 对整体消耗的优化 (total cost minimization)

- 容错(故障恢复能力)的优化 (failure-resilient distributed DNN model)

和之前两种范式相比, 云边端协同的 DNN 推理具有如下优势:

- 更高的资源利用率 (通过细粒度模型划分, 充分利用各端设备的资源)

- 更强的故障恢复能力 (弹性分布式系统模型)

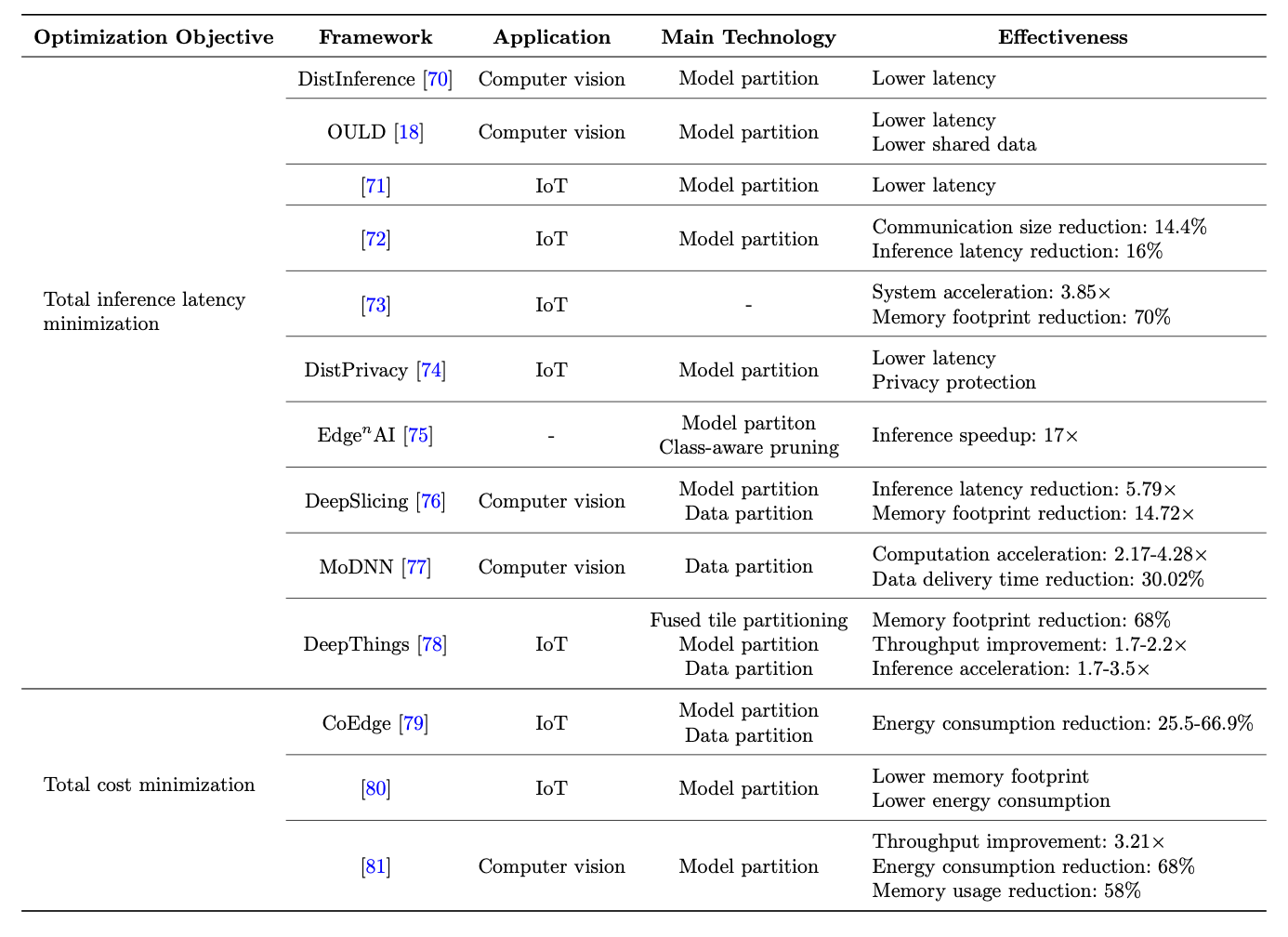

4 - Device-device collaborative DNN inference

device-device 协同的 DNN 推理具有几个重要的优势: 更多的本地计算资源, 更高的隐私性, 并且对网络带宽的依赖更低, 该范式最适合在高移动场景和一些通信环境恶劣的环境, 并且由于终端设备成本低廉, 可以部署在任何地方.

这种范式的主要瓶颈在于移动设备的资源有限, 因此优化目标主要集中在推理延迟和能耗上

本文将一般的 device-device DNN 推理的优化目标分为如下两类:

- 对推理延迟的优化 (total inference latency)

- 对整体消耗的优化 (total cost minimization)

device-device 范式主要的不足之处在于:

- 数据安全: 多设备协同推理需要相互之间频繁地传递数据, 数据的频繁传输会面临通信开销, 数据丢失和隐私泄露的风险

- 异构设备: 不同设备具有异构性, 计算能力, 带宽也会不一样, 会出现数据同步时的等待问题, 从而降低整体的推理效率并增加端到端延迟

- 能耗问题: 由于电池容量的限制,对于协同推理任务,需要细粒度的设备调度策略和任务分配策略,以最小化整体能耗; 只有各设备的剩余电量与任务量的匹配才能保证整个推理系统的完整运行